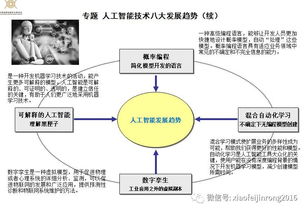

近幾年,深度學習技術席卷全球,從語音識別到圖像分類,從自動駕駛到醫療診斷,這項人工智能的核心技術正在徹底改變我們的生活和工作方式。神經網絡模型通過海量數據的訓練,實現了過去難以想象的精準預測和決策能力,這無疑是科技發展史上的重要里程碑。

在這片繁榮景象背后,我們必須清醒地認識到:當前的人工智能研究應用距離真正的智能還有很長的路要走。深度學習系統雖然在特定任務上表現出色,但它們缺乏人類的理解能力、常識推理和創造性思維。這些系統更像是精密的模式匹配機器,而非真正的智能體。

更令人擔憂的是,智能世界的構建并非如表面看起來那般美好。隨著算法在社會各個領域的深入應用,一系列潛在危機正悄然浮現:

算法偏見已成為不容忽視的問題。訓練數據的偏差會導致模型產生歧視性決策,這在招聘、信貸和司法等關鍵領域可能造成嚴重的社會不公。

深度學習系統的"黑箱"特性使得決策過程難以解釋。當AI系統做出錯誤判斷時,我們往往無法追溯其原因,這在醫療診斷、自動駕駛等高風險應用中尤為危險。

數據隱私和安全面臨前所未有的挑戰。大規模數據收集和模型訓練過程中,個人信息的保護和系統的安全性成為懸在頭頂的達摩克利斯之劍。

從軟件開發的角度看,這些問題對開發者和企業提出了更高要求。單純的算法優化已不足以應對這些復雜挑戰,我們需要在系統設計中融入倫理考量和安全防護,建立更加透明、可信的AI系統。

未來的人工智能發展應當走向更加平衡的道路:既追求技術進步,又重視社會影響;既發展智能算法,又保障人類價值。只有在技術創新與人文關懷之間找到恰當平衡,我們才能真正構建一個安全、公平、可持續的智能未來。